技术SEO实战指南:让搜索引擎爬虫 “爱上” 你的网站,从抓取到转化一步到位

搜索引擎爬虫(Googlebot)能否顺利访问你的网站,是决定内容能否被索引、能否出现在搜索结果中的关键前提。哪怕你写出了行业顶尖的内容、布局了精准的关键词,若爬虫 “看不见” 你的页面,所有努力都会付诸东流。

一、先搞懂:搜索引擎爬虫是怎么 “发现” 和 “看懂” 你的页面?

要做好抓取优化,首先得站在爬虫的角度思考 —— 它如何找到你的页面?又如何理解页面内容?这两个问题,决定了后续优化的方向。

爬虫找页面的 3 条核心路径,别漏了关键环节,谷歌爬虫发现新 URL,主要依赖三个渠道,其中 “外部链接” 和 “内部链接” 是重中之重:

- 外部链接(Backlinks):其他网站指向你的链接,相当于 “别人给你推荐”,是爬虫发现新站点最有效的方式。比如行业权威博客引用了你的文章,爬虫顺着这个链接就能找到你的网站。

- 内部链接(Internal Links):你网站内部页面的互相跳转,像一张 “导航网”。爬虫会从首页出发,顺着导航栏、文章内的锚文本,一步步探索所有关联页面。

- 站点地图(Sitemaps):你主动提交给谷歌的 “页面清单”,适合新网站或页面结构复杂的站点。提交站点地图不代表爬虫一定会爬,但能给它提供清晰的指引,减少遗漏重要页面的概率。

二、爬虫 “看懂” 页面的关键:渲染方式决定 SEO 友好度

找到页面后,爬虫还需要 “读懂” 内容,而网站的 “渲染方式” 直接影响它的理解效率:

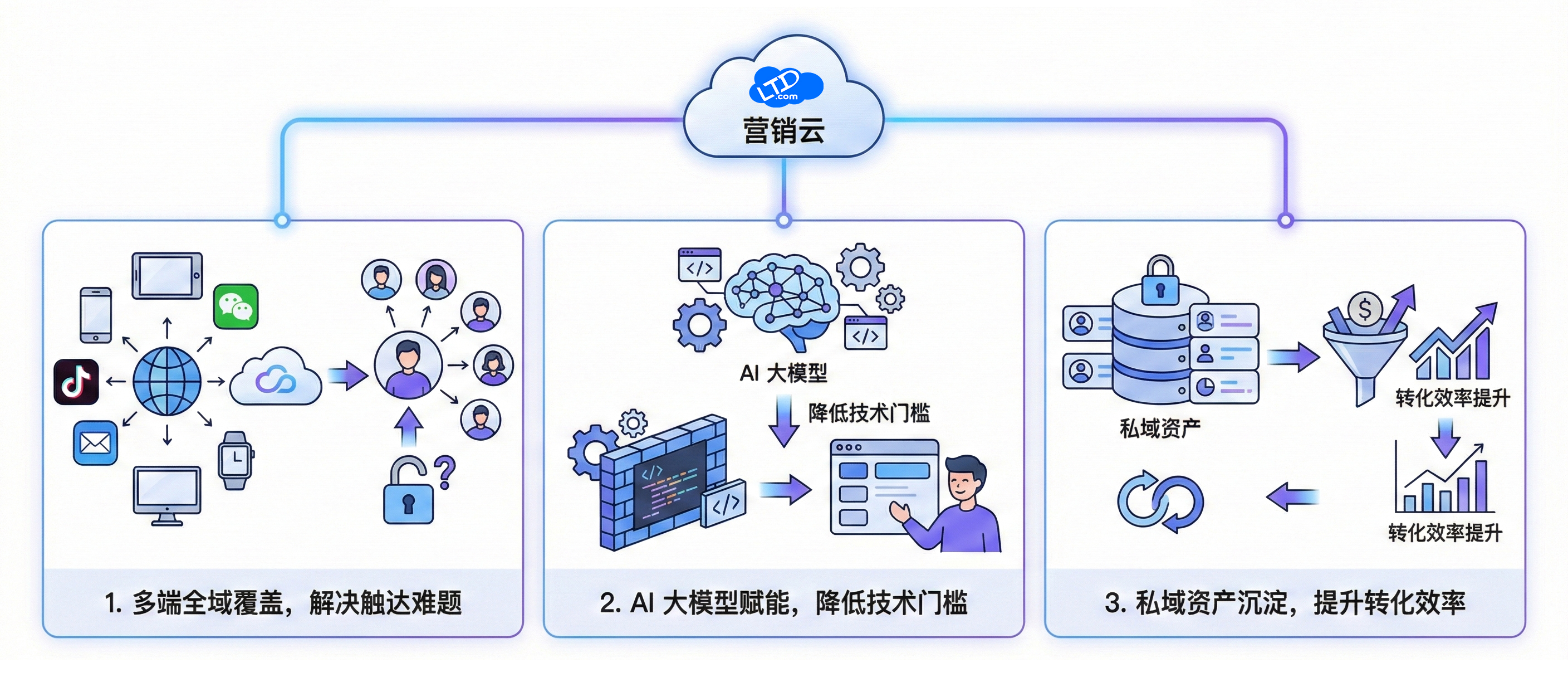

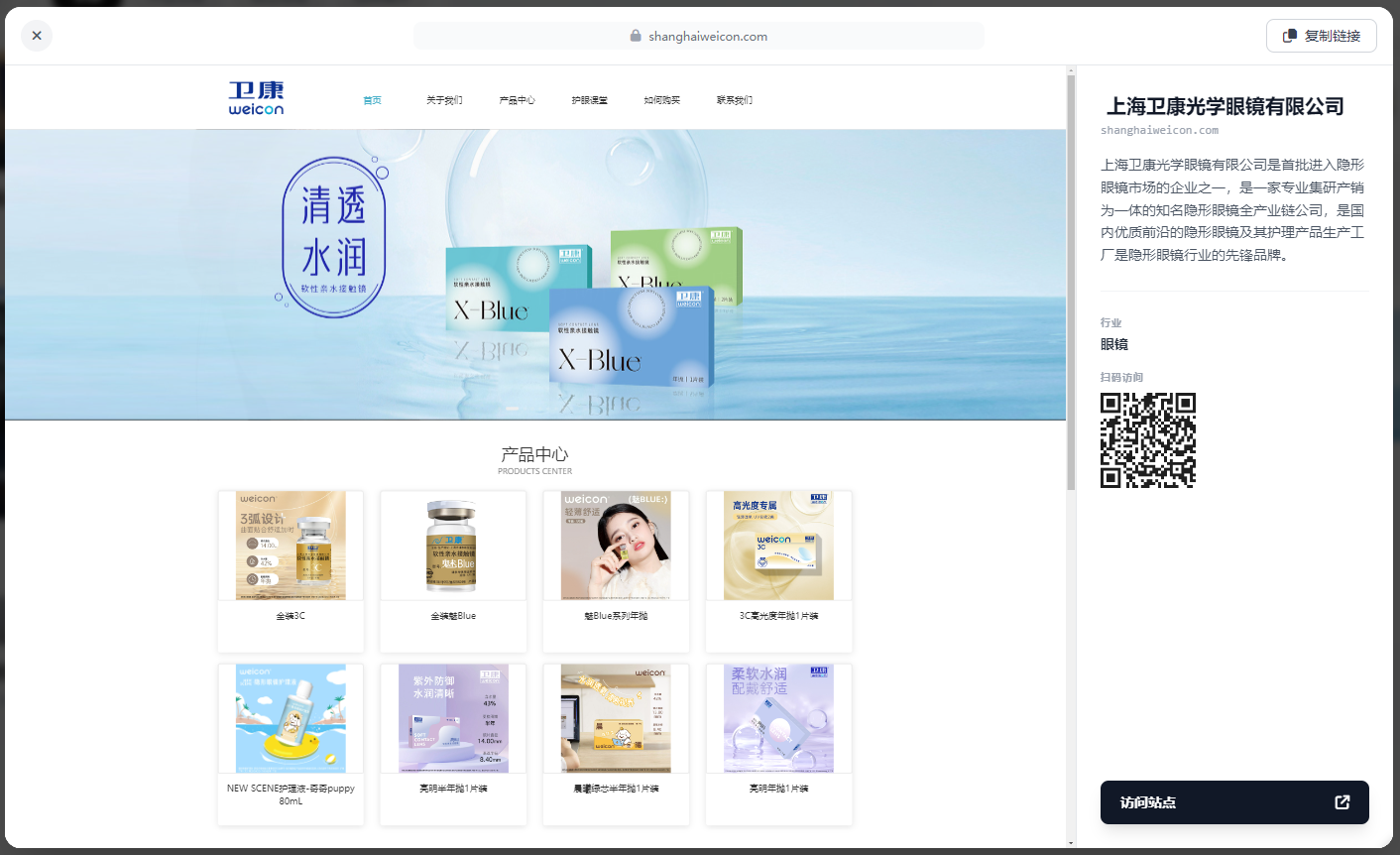

- 服务端渲染(SSR)/ 静态站点生成(SSG):SEO 友好型。相当于给爬虫递上一本 “印刷好的书”,页面内容在服务器端已生成完整的 HTML 代码,爬虫打开就能直接读取,无需额外处理。像 营销枢纽就是这样处理的自助建站平台系统:https://wei.ltd.com/?=daohang

- 客户端渲染(CSR):SEO 不友好型。页面加载时先返回一堆 JavaScript 代码,爬虫需要 “解析代码” 才能生成内容,过程中可能出现解析不完整的情况,导致核心信息被遗漏。常见于用 React、Vue 纯前端框架搭建的网站(无服务端配置时)。

做好抓取优化,只是技术 SEO 的第一步。记住,技术 SEO 的核心不是 “讨好” 爬虫,而是通过优化网站结构,让爬虫更高效地发现有价值的内容,最终实现 “搜索流量提升→用户转化增加” 的目标。

*部分文字含AI生成内容

请先 登录后发表评论 ~